Los enormes requerimientos energéticos de compañías como Amazon, Google y Facebook revelan el lado menos sustentable de Internet, con centros de datos que requieren el equivalente a la energía que consume una ciudad entera.

Las máquinas de Jeff Rothschild en Facebook tenían un problema que sabía que tendría que resolver inmediatamente. Estaban por fundirse. La compañía había estado llenando un espacio alquilado de 13 por 20 metros con estantes de servidores que se necesitaban para almacenar y procesar información de las cuentas de los usuarios. La electricidad que alimentaba las computadoras estaba sobrecalentando los conectores Ethernet y otros componentes cruciales.

Pensando rápidamente, Rothschild, el jefe de ingenieros de la compañía, se llevó algunos empleados en una expedición para comprar todos los ventiladores que pudieran encontrar -“Dejamos sin ventiladores a todas las tiendas Walgreen de la zona”, dijo- para lanzar aire fresco sobre los equipos y evitar que se cayera el sitio en la Red.

Eso fue a comienzos de 2006, cuando Facebook tenía apenas 10 millones de usuarios aproximadamente y solo un sitio de servidores principal. Hoy la información generada por casi mil millones de personas requiere versiones gigantescas de estas instalaciones, llamadas centros de datos, con filas y más filas de servidores en cientos de miles de metros cuadrados y con sistemas de refrigeración industriales.

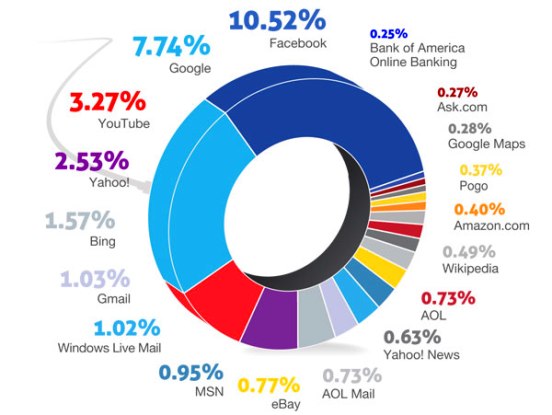

Y estos son una mínima parte de las decenas de miles de centros de datos que existen ahora para sostener la explosión general de información digital. Cantidades estupendas de datos son puestas en movimiento cada día cuando con un clic o toque inocuo la gente descarga películas de iTunes, mira el balance de sus tarjetas de crédito a través del sitio de Visa, envía correo electrónico a través de Yahoo con archivos agregados, compra productos en Amazon, twitea o lee los diarios online.

Un examen a lo largo de un año de The New York Times ha revelado que estos cimientos de la industria informática están en fuerte contradicción con su imagen de acerada eficiencia y de ser amigable con el medio ambiente.

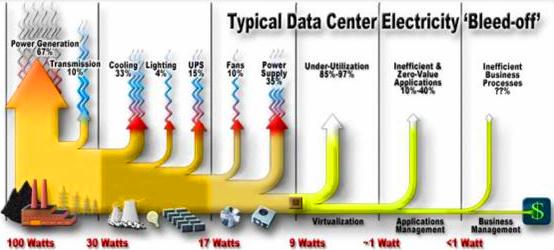

La mayoría de los centros de datos están diseñados de tal modo que incongruentemente malgastan cantidades inmensas de energía, según muestran entrevistas y documentos. Las compañías con sitios en la red comúnmente mantienen a sus instalaciones a capacidad máxima las 24 horas del día no importa la demanda que tengan. Como resultado de ello, los centros de datos pueden llegar a malgastar el 90 por ciento o más de la energía que obtienen de las redes eléctricas, según descubrió el Times.

Para cubrirse contra cortes, utilizan además bancos de generadores con emisiones de humo de diesel. La polución de los centros de datos ha sido denunciada cada vez más por las autoridades por violar las regulaciones de aire limpio. En Silicon Valley, muchos centros de datos aparecen en el Inventario de Contaminantes Tóxicos del Aire, una lista de los principales centros estacionarios de polución diesel de la región.

A nivel mundial, los almacenes digitales usan alrededor de 30.000 millones de vatios de electricidad, aproximadamente el equivalente de la producción de energía de 30 plantas nucleares, según estimados del sector compilados por expertos para el Times. De acuerdo a los estimados los centros de datos de los Estados Unidos dan cuenta de entre un cuarto y un tercio de esa carga.

“Para la mayoría de la gente, incluso gente del sector, es casi imposible entender las cifras por el increíble tamaño de estos sistemas” dijo Peter Gross, que ayudó a diseñar cientos de centros de datos. “Un solo centro de datos puede recibir más energía que una ciudad mediana”.

La eficiencia en el consumo de energía varía mucho de una empresa a otra. Pero a pedido del Times, la firma consultora McKinsey & Company analizó el uso de energía por cada centro de datos y descubrió que, en promedio, utilizaban sólo entre el 6 y el 12 por ciento de la electricidad que alimenta a sus servidores para realizar cálculos computacionales. El resto esencialmente se usa para mantener a los servidores ociosos y a disposición en caso de que se produzca un pico de actividad que pueda hacer más lentas sus operaciones o hacer caer sus sistemas.

Un servidor es una especie de computadora de escritorio más poderosa, sin pantalla ni teclado, que contiene chips para procesar datos. El estudio tomó muestras de unos 20.000 servidores en alrededor de 70 centros de datos grandes, de todo el espectro comercial: compañías farmacéuticas, contratistas militares, bancos, compañías de medios y entes gubernamentales.

“Este es el sucio secreto del sector y nadie quiere ser el primero en hacer un mea culpa”, dijo un alto ejecutivo que pidió no ser identificado para proteger la reputación de su compañía. “Si fuéramos una industria manufacturera quebraríamos de inmediato”.

Estas realidades físicas de los datos están lejos de la mitología de internet: donde las vidas se viven en el mundo “virtual” y se guarda todo tipo de información en “la nube”.

El uso ineficiente de la energía está motorizado en gran medida por una relación simbiótica entre los usuarios que demandan una respuesta instantánea al clic de un mouse y las compañías que ponen en riesgo su negocio si no responden a esa expectativa.

Ni siquiera la utilización de la electricidad a toda máquina ha sido suficiente para satisfacer al sector. Además de generadores, la mayoría de los centros de datos contienen bancos de inmensos molinos (flywheels, en inglés) o miles de baterías de plomo -muchas de ellas similares a las baterías de auto- para alimentar a las computadoras en caso de un corte de las redes de una centésima de segundo, interrupción que podría hacer caer los servidores.

“Es un desperdicio” dijo Dennis P. Symanski, investigador del Electirc Power Research Institute, un grupo industrial sin fines de lucro. “Son demasiadas pólizas de seguro”. Se ha denunciado al menos una docena de importantes centros de datos por violaciones de las normas que protegen la calidad del aire tan solo en los estados de Virginia e Illinois, de acuerdo a los registros estaduales. Hubo más de 24 denuncias de violaciones por parte de Amazon en un período de tres años en el norte de Virginia, incluyendo acusaciones de hacer funcionar algunos de sus generadores sin el permiso ambiental básico. Unas pocas compañías dicen que usan software actualizado y sistemas de refrigeración para reducir el malgaste de energía. Entre ellas se cuentan Facebook y Google, que también han rediseñado sus máquinas. Aún así, según informaciones recientes, los centros de datos de Google consumen cerca de 300 millones vatios y los de Facebook alrededor de 60 millones de vatios.

Muchas de estas soluciones están disponibles y son fácilmente accesibles, pero en un sector que le huye al riesgo, la mayoría de las compañías han sido renuentes a instrumentar cambios generales, según expertos del sector.

Mejorar o incluso evaluar el terreno es complicado por el carácter secreto de un sector que se basa en gran medida en acceder a los datos personales de la gente. Por motivos de seguridad, las compañías comúnmente ni siquiera revelan la ubicación de sus centros de datos, albergados en edificios anónimos y protegidos con fuerte vigilancia. Las compañías también protegen su tecnología por motivos de competencia, dijo Michael Manos, un ejecutivo de larga experiencia en el sector. “Todo eso se realimenta para promover este tipo de grupo cerrado, solo por los miembros”, dijo.

Ese manejo secreto a menudo abarca también el uso de energía. La cosa se ve aún más complicada porque no hay un solo ente oficial que tenga autoridad para seguir el sector. De hecho, el gobierno federal fue incapaz de determinar cuanta energía consumen sus propios centros de datos, según funcionarios que participaron de una encuesta realizada el año pasado. La encuesta descubrió que el número de centros de datos federales creció de 432 en 1998 a 2094 en 2010.

Para investigar el sector el Times obtuvo miles de páginas de registros municipales, estaduales y federales que se guardan en instalaciones que usan gran cantidad de energía, en parte gracias a las disposiciones de las leyes de libre disponibilidad de la información. Se obtuvo copias de permisos para generadores e información sobre sus emisiones de entes ambientales, que ayudaron a encontrar la ubicación de algunos centros de datos y detalles de sus operaciones.

Además de estudiar los registros de usinas eléctricas, el Times también visitó centros de datos de todo el país y realizó cientos de entrevistas con actuales y ex empleados y contratistas.

Algunos analistas alertan que de seguir en aumento la cantidad de datos y energía utilizados, las compañías que no alteren sus prácticas eventualmente podrían enfrentarse a un sacudón en un sector que ha sido proclive a las grandes conmociones, incluyendo el estallido de la primera burbuja de internet a fines de la década de 1990.

“Simplemente no se puede sostener” dijo Mark Bramfitt, ex ejecutivo de una usina que ahora es consultor de industrias de alta tecnología relacionadas con la energía y la informática. “Se van a estrellar contra una pared de ladrillos”.

Bytes por miles de millones

Vestido con una remera del FC Barcelona y bermudas a cuadros, Andre Tran caminaba por un centro de datos de Yahoo! en Santa Clara donde es el gerente de operaciones. El dominio de Tran -hay servidores destinados a deportes virtuales y almacenado de fotos, entre otras cosas- es una buena muestra de las incontables salas de computadoras por las que pasan o donde vienen a morir las correntadas de datos del planeta.

En el suelo blanco, con pequeños agujeros redondos que lanzaban aire frío, había fila tras fila de servidores, con luces ámbar, azules y verdes que destellaban silenciosas. Dentro de cada servidor había discos rígidos giratorios que almacenan los datos. El único indicio de que el centro es de Yahoo!, cuyo nombre no aparecía por ningún lado, podía encontrarse en un enredo de cables violetas y amarillos, los colores de la compañía.

“Podría haber miles de correos electrónicos en estos” dijo Tran, señalando una fila de almacenado. “La gente guarda los viejos correos electrónicos y sus archivos anexados para siempre, por lo que se necesita mucho espacio”.

Este es el rostro mundano de la información digital: estadísticas de jugadores que fluyen hacia los servidores que calculan los puntos de fantasía y los rankings de las ligas, fotos de vacaciones casi olvidadas guardadas en dispositivos de almacenado. Es cuando se suman las repeticiones de estas y otras transacciones similares que todo resulta impresionante.

Cada año los chips de servidores se vuelven más rápidos y los medios de almacenamiento se vuelven más densos y baratos, pero la tasa descontrolada de producción de datos sube un escalón.

Jeremy Burton, experto en almacenado de datos, dijo que cuando trabajó en una compañía de tecnología computacional hace 10 años, el cliente más dato-intensivo con el que trato tenía unos 50.000 gigabytes en toda su base de datos. (El almacenamiento de datos se mide en bytes. La letra N, por ejemplo, ocupa un byte. Un gigabyte es el nombre para definir mil millones de bytes de información.)

Hoy, aproximadamente se procesa y almacena un millón de gigabytes en un centro de datos durante la creación de una sola película 3D animada, dijo Burton, ahora en EMC, una compañía que se concentra en la administración y almacenado de datos.

Solo uno de los clientes de la compañía, la Bolsa de New York, produce hasta 2000 gigabytes de datos por día, que deben ser almacenados por años, agregó.

EMC y la International data Corporation juntas estimaron que más de 18,8 billones de gigabytes de información digital fueron creados globalmente el año pasado.

“Es absolutamente una carrera entre nuestra capacidad para crear datos y nuestra capacidad para almacenar y manejar datos” dijo Burton.

Alrededor de tres cuartos de los datos, según estimó EMC, fueron creados por consumidores comunes.

Sin noción de que la información es física o que almacenarla ocupa espacio y consume energía, esos consumidores han desarrollado el hábito de enviar archivos inmensos de datos de un lado a otros, como en el caso de los videos y los correos electrónicos con fotos adjuntas. Incluso acciones mundanas como hacer funcionar una aplicación para encontrar un restorán italiano en Manhattan o un taxi en Dallas requieren servidores que estén encendidos y preparados para procesar la información de modo instantáneo.

La complejidad de una transacción básica es un misterio para la mayoría de los usuarios: enviar un mensaje con fotos a un vecino podría involucrar un viaje a través de cientos o miles de kilómetros de conductos de internet y múltiples centros de datos antes de que el correo llegue al otro lado de la calle.

“Si uno le dice a alguien que no puede acceder a YouTube o descargar desde Netflix, reaccionará como si le estuviera quitando un derecho concedido por Dios a los hombres” dijo Bruce Taylor, vicepresidente del Uptime Institute, una organización profesional para compañías que usan centros de datos. Para soportar toda esa actividad digital, ahora hay más de tres millones de centros de datos de tamaño muy diverso en el mundo, según cifras de la International Data Corporation.

A nivel de todo Estados Unidos, los centros de datos usaron alrededor de 76 mil millones de kilovatios hora en 2010, o aproximadamente el 2 por ciento de la electricidad utilizada en el país ese año, según un análisis de Jonathan G. Koomey, un investigador de Stanford University, que ha estado estudiando el uso de energía por los centros de datos desde hace más de una década. DatacenterDynamics, una firma con sede en Londres, derivó cifras similares.

El sector ha sostenido desde hace mucho que computarizar las transacciones de negocios y las tareas cotidianas como los trámites bancarios y leer libros de una biblioteca tiene el efecto neto de ahorrar energía y recursos. Pero la industria del papel, que algunos predijeron que sería reemplazada por la era de la computadora, consumió 67.000 millones de kilovatios hora de la red en 2010, según cifras de la Oficina del Censo analizadas por el Electric Power Research Institute para el times.

Las comparaciones directas entre los sectores son difíciles: el papel usa energía adicional quemando los desperdicios de pulpa y en el transporte de productos Del mismo modo, los centros de datos involucran decenas de millones de laptops, computadoras personales y dispositivos móviles. Chris Crosby, CEO de Compass Datacenters con sede en Dallas, dijo que no hay a la vista un fin de la proliferación de infraestructura digital. “Hay nuevas tecnologías y avances -dijo Crosby- pero todo sigue funcionando con un cable de electricidad”.

Drenajes “comatosos” de energía

Ingenieros de Viridity Software, una nueva firma que ayuda a compañías a administrar recursos energéticos, no se vieron sorprendidos por lo que descubrieron en el piso de un extenso centro de datos cerca de Atlanta.

Se había contratado a Viridity para realizar pruebas de diagnóstico básicas. Los ingenieros encontraron que las instalaciones, como docenas más que habían estudiado, usaba la mayor parte de la energía para servidores que hacían poco más que quemar electricidad, dijo Michael Rowan, que era el principal jefe de tecnología de Viridity.

Un alto funcionario del centro de datos ya sospechaba que algo andaba mal. Había realizado su propia investigación informal, colocando etiquetas rojas en servidores que creía “comatosos”, el término que usan los ingenieros para servidores que están enchufados y consumen energía mientras sus procesadores hacen poco o ningún trabajo computacional.

“Al final de ese proceso, lo que se descubrió es que nuestro centro de datos tenía viruela” dijo el funcionario, Martin Stephens, en un seminario a través de la red con Rowan. “Había tantas etiquetas rojas que era increíble”.

Las pruebas de Viridity respaldaron las sospechas de Stephens: en una muestra de 333 servidores controlados en 2010, más de la mitad resultaron comatosos. En total tres cuartos de los servidores de la muestra estaban usando menos de un 10 por ciento de su poder computacional, en promedio para procesar datos.

El operador del centro de datos no era un diseñador de aplicaciones del montón ni una compañía de apuestas online, sino LexisNexis, el gigante de las bases de datos. Y no era para nada un caso único. En muchas instalaciones, se cargan aplicaciones en los servidores y se los deja funcionar indefinidamente, incluso después de que todos los usuarios han desaparecido o hay nuevas versiones de los mismos programas funcionando en otras máquinas.

“Hay que entender que la explosión de la generación de datos es lo que promueve esto” dijo Taylor del Uptime Institute. “En un cierto punto ya no hay nadie responsable porque nadie, absolutamente nadie, quiere ir a esa sala y desenchufar un servidor”.

Kenneth Brill, un ingeniero que en 1993 fundó el Uptime Institue, dijo que la baja utilización comenzó con el “pecado original” de este campo.

A comienzos de la década de 1990, explicó Brill, los sistemas operativos de software que ahora se considerarían primitivos se caían si se les pedía que hicieran demasiadas cosas o incluso si se los arrancaba y apagaba. En respuesta, los técnicos en computación rara vez hacían funcionar más de una aplicación en cada servidor y mantenían las máquinas encendidas las 24 horas, no importa lo esporádica que fuera la utilización de esa aplicación por los usuarios.

De modo que mientras los entes oficiales de control del consumo de energía urgían a los consumidores a apagar sus computadoras cuando no las usaban, la directiva fundamental dirigida a los centros datos pasó a ser mantener las computadoras andando a toda costa.

Una caída de un sistema o una baja en la velocidad de operación podía terminar con una carrera, dijo Michael Tresh, ex alto ejecutivo de Viridity. Un campo nacido del ingenio y la audacia ahora está dominado por otra cosa: el temor al fracaso.

“Los operadores de centros de datos viven temerosos de perder sus puestos de trabajo diariamente” dijo Tresh. “Y eso se debe a que las firmas no los respaldan si hay una falla”. En términos técnicos la fracción del poder de una computadora que se está usando para cálculos se llama “utilización”.

McKinsey & Company, la firma consultora que analizó cifras de utilización para el Times, ha estado monitoreando la cuestión al menos desde 2008, cuando publicó un informe que recibió poca atención fuera del campo. Las cifras se mantienen tercamente bajas: los resultados actuales, que indican una “utilización” del 6 al 12 por ciento son solo ligeramente mejores que las de 2008. Debido a acuerdos de confidencialidad, Mckinsey no puede nombrar a las compañías de las que se obtuvieron las muestras.

David Cappuccio, vicepresidente ejecutivo y jefe de investigaciones de Gartner, una firma de estudios de tecnología, dijo que su propio estudio reciente de una gran muestra de centros de datos descubrió que los niveles de utilización típicos van del 7 al 12 por ciento.

“Es así cómo hemos sobre-aprovisionado y manejado centros de datos durante años” dijo Cappuccio. “‘Construimos demás para el caso de que lo necesitemos’, ese nivel de tranquilidad cuesta mucho dinero. Cuesta mucha energía”.

Los servidores no son los únicos componentes de los centros de datos que consumen energía. También consumen su parte los sistemas de refrigeración industrial, los circuitos para mantener cargadas las baterías de respaldo y la simple disipación de calor de tanto aparataje y cables.

En un típico centro de datos esas pérdidas combinadas con la baja utilización pueden significar que la energía desperdiciada equivale a hasta 30 veces la cantidad de electricidad utilizada para realizar el propósito básico del centro de datos.

Algunas compañías, organizaciones académicas y grupos de investigación han mostrado que son posibles prácticas mucho más eficientes, aunque es difícil comparar distintos tipos de tareas.

El National Energy Research Scientific Computing Center, que consiste de conjuntos de servidores y computadoras grandes (mainframe) del Lawrence Berkeley National Laboratory en California, funcionó con una utilización del 96,4 por ciento en julio, dijo Jeff Broughton, director de operaciones. La eficiencia se logra haciendo colas de trabajos grandes y programándolos de modo de que las máquinas funcionen casi a capacidad completa las 24 horas del día. Una compañía llamada Power Assure, con sede en Santa Clara, comercializa una tecnología que permite a centros de datos comerciales apagar servidores de modo seguro cuando no se los necesita, por ejemplo, por la noche.

Pero incluso con programas agresivos para alentar a sus principales clientes a ahorrar energía, Silicon Valley Power no ha logrado persuadir a un solo centro de datos de usar la técnica en Santa Clara, dijo Mary Medeiros McEnroe, gerenta de programas de eficiencia energética de la usina. “Hay temor en la comunidad TI de que algo no va ya estar disponible cuando lo necesiten”, dijo McEnroe.

La eficientización del centro de datos por Stephens para LexisNexis Risk Solutions es una ilustración de los ahorros que pueden lograrse.

En la primera fase del proyecto, dijo que consolidando el trabajo en menos servidores y actualizando el equipo, pudo reducir instalaciones de 8000 metros cuadrados a 3500 metros cuadrados.

Por supuesto que los centros de datos deben tener algo de capacidad de respaldo disponible en todo momento y no es posible lograr una utilización del 100 por ciento. Deben estar preparados para manejar picos de tráfico.

Symanski del Electric Power Research Institute, dijo que eficiencias tan bajas solo tienen sentido en el marco de la oscura lógica de la infraestructura digital. “Uno lo mira y dice: ‘¿Cómo se puede manejar un negocio así?'”, dijo Symanski. La respuesta es a menudo la misma, dijo. “No reciben un premio por ahorrar en la cuenta de electricidad. Tienen premio por lograr que el centro de datos esté disponible el 99,999 por ciento del tiempo”.

Los planes mejor elaborados

En Manassas, Virginia, el coloso de las ventas minoristas Amazon tiene servidores para su nube, en medio de un depósito de camiones, un elevador de granos en desuso, un aserradero y lotes llenos de basura donde máquinas comprimen cargas de desperdicios para su reciclado.

Los servidores están en dos centros de datos de Amazon en tres edificios con la forma de depósitos grandes, con paredes de metal corrugado verde. En los techos hay ductos de aire lo suficientemente grandes como para acomodar sistemas de refrigeración industrial; en el exterior hay filas de inmensos generadores diesel.

El término “nube” se usa en general para describir las funciones del centro de datos. Más específicamente, se refiere a un servicio de alquiler de capacidad computacional. Estas facilidades obtienen energía principalmente de la red troncal nacional, pero casi siempre hay generadores y baterías presentes para proveer electricidad si la red se apaga.

Los sitios de Manassas se cuentan entre los ocho principales centros de datos que opera Amazon en el norte de Virginia, según registros del Departamento de Calidad Ambiental del estado.

El departamento conoce bien a Amazon. Como resultado de cuatro inspecciones a partir de octubre de 2010, se le dijo a la compañía que tendría una multa de US$ 554.476 del ente por instalar y operar repetidamente generadores diesel sin obtener permisos ambientales estándar requeridos para operar en Virginia.

Aunque no hay apagones, los generadores de respaldo siguen lanzando emisiones porque regularmente tienen que ser probados.

Luego de meses de negociaciones, la multa se redujo a US$ 261.638. En un juicio de “grado de culpabilidad”, a las 24 violaciones se las consideró de ranking “elevado”.

Drew Herdener, vocero de Amazon, reconoció que la compañía “no obtuvo los permisos indicados” antes de encender los generadores. “Todos estos generadores luego fueron permitidos y aprobado” dijo Herdener.

Las violaciones vinieron acompañadas de una serie de infracciones menores en uno de los centros de datos de Amazon en Ashburn, Virginia, en 2009, por las que la compañía pagó US$ 3496, según registros del departamento.

Puede decirse con certeza que entre las cosas que se preveía de Internet, nunca se incluyó la de semilla de proliferación de generadores diesel de respaldo.

Terry Darton, ex gerente del ente ambiental de Virginia, dijo que los permisos que se habían otorgado para generadores de centros de datos en este rincón de 14 condados de Virginia equivalen casi a la potencia instalada de una planta nuclear.

“Es shockeante la cantidad de energía potencial que hay” dijo Darton, que se jubiló en agosto.

No hay cifras nacionales sobre violaciones ambientales de centros de datos, pero un chequeo de varios distritos ambientales sugiere que los centros están comenzando a llamar la atención de los reguladores en todo el país.

A lo largo de los últimos cinco años en la zona de Chicago, por ejemplo, potencias de internet como Savvis y Equinix recibieron notificaciones por violaciones, según registros del ente Illinois Environmental Protection Agency. Aparte de Amazon, funcionarios del norte de Virginia también han citado a centros de datos de Qwest, Svvis VeriSign y NTT America.

Pese a todas las precauciones -el enorme flujo de electricidad, los bancos de baterías y las filas de generadores diesel- los centros de datos aún se caen.

Amazon, en particular, ha visto fallas en Virginia del norte en los últimos años. En mayo de 2010 se dio una en las instalaciones en Chantilly, dejando desconectadas empresas dependientes de la nube de Amazon por más de una hora, lo que es una eternidad en el negocio de los datos. Encontrar la causa se convirtió en un problema serio de informática.

Amazon anunció que la falla “se produjo cuando un vehículo chocó contra un poste que sostiene cables de alto voltaje en un camino cercano a uno de nuestros centros de datos”.

Resultó que el accidente automotriz era un mito, un malentendido transmitido de un operador de la empresa de energía local a un trabajador del centro de datos y de allí a la sede de Amazon. Amazon reconoció luego que fue resultado de que sus equipos de respaldo por error apagó parte del centro de datos luego de lo que Dominion Virginia Power dijo que fue un corto en un poste eléctrico que provocó dos fallas momentáneas.

Herdener de Amazon dijo que el sistema de respaldo fue rediseñado y “no esperamos que esto se repita”.

La fuente del problema

El año pasado en el Nordeste, entró en operaciones una línea de alimentación de la red nacional que costó US$ 1000 millones, viboreando a través de aproximadamente 350 kilómetros desde el sudeste de Pensilvania a través de los montes Allegheny en Virginia Occidental y terminando en Loudon County, Virginia.

El trabajo fue financiado por las tarifas que pagan millones de clientes comunes. Steven R. Herling, un alto funcionario de PJM Interconnection, una autoridad regional de la red, dijo que la necesidad de alimentar los centros de datos en fuerte crecimiento en el norte de Virginia fue “el punto que obligó a implementar el proyecto” en una economía que viene en baja.

Los centros de datos de la zona ahora consumen casi 500 millones de vatios de electricidad, dijo Jim Norvelle, vocero de Dominion Virginia Power, la principal compañía eléctrica allí. Dominion estima que la carga podría aumentar a más de mil millones de vatios en los próximos cinco años.

Los centros de datos se cuentan entre los clientes más valorados por las compañías de electricidad. Muchas empresas de todo el país reclutan las instalaciones por sus cargas casi sin variantes las 24 horas. El consumo grande y estable es rentable para las empresas de distribución eléctricas porque les permite planificar sus propias compras de energía por adelantado y comercializar sus servicios por la noche cuando caer a pico la demanda de otros clientes.

Bramfitt, el ex ejecutivo de la empresa de electricidad, dijo que teme que esta dinámica aliente a un sector que malgasta tanta energía a aferrarse a sus hábitos de pedal a fondo. Aún con toda la energía y los equipos que se vuelcan a este campo, otros creen que los actuales métodos de almacenado y procesamiento de datos tendrán serias dificultades para responder al tsunami digital.

Algunos expertos del sector creen que la solución está en la nube: centralizar la computación en centros grandes y bien operados. Esos centros de datos se basarían mucho en una tecnología llamada virtualización, que de hecho permite a los servidores fusionar sus identidades en grandes recursos de computación flexibles que pueden ser utilizados por los usuarios en la medida que los necesiten, no importa donde estén.

Un partidario de esa postura es Koomey, el experto del centro de datos de Stanford. Pero dijo que muchas compañías que tratan de manejar sus propios centros de datos, ya sea en sus propias instalaciones o en espacios alquilados, aún no se han familiarizado o desconfían de la nueva tecnología de la nube.

Desgraciadamente esas compañías dan cuenta de la mayor parte del uso de energía por centros de datos dijo Koomey.

Otros expresan profundo escepticismo respecto de la nube, diciendo que la creencia a veces mística en sus posibilidades se contrapone a la infraestructura física que se necesita para sostenerla.

Usar la nube “solo cambia dónde corren las aplicaciones” dijo Hank Seader, director ejecutivo para investigación y educación del Uptime Institute. “Todo va a un centro de datos en algún lugar.”.

Algunos se preguntan si el lenguaje mismo de internet no es una barrera para comprender lo física que es la Red. Basta pensar, por ejemplo, en la cuestión de almacenar datos, dice Randall H. Victora, profesor de ingeniería eléctrica de la universidad de Minnesota que hace investigación de dispositivos de almacenamiento magnético.

“Cuando alguien dice ‘voy a guardar algo en la nube, ya no necesitamos discos rígidos’, no advierte que la nube está compuesta de discos rígidos”, dijo Victora. “Los tenemos de una manera o de otra. Simplemente no lo sabemos”.

Sea lo que sea que suceda dentro de las compañías, está claro que entre los consumidores lo que ahora son expectativas establecidas es lo que impone la necesidad de una infraestructura tan formidable.

“Es eso lo que impulsa ese crecimiento masivo, la expectativa del usuario final de cualquier cosa, en cualquier momento, en cualquier lugar” dijo David Cappuiccio, vicepresidente ejecutivo y jefe de investigaciones de Gartner, la firma de investigaciones tecnológicas. “Nosotros somos lo que causa el problema”.

Por: James Glanz

Fuente: Power, Pollution and the Internet – The New York Times

Información relacionada

Datacenters en Islandia para ahorrar energía

Internet consume el 2% de la energía mundial

Las razones de Google para invertir en energía

Ahora Google se suma al negocio de la energía eólica